本文介绍云端一键部署以及API调用推理模型QwQ-32B的方法:

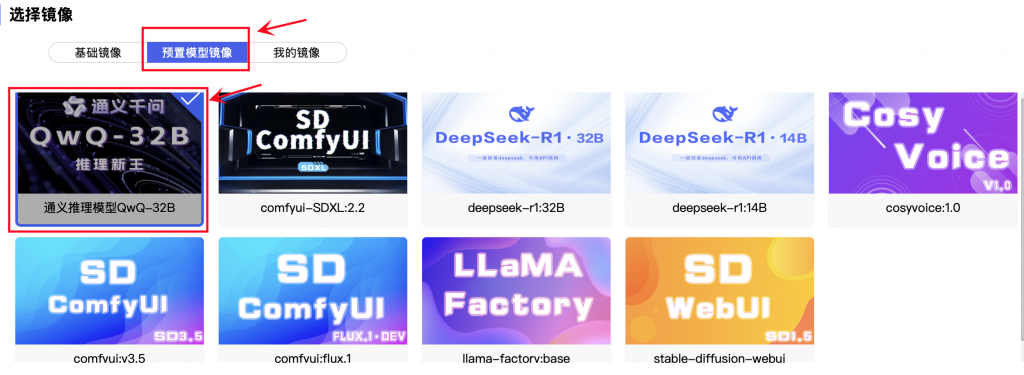

step 1:找到QwQ-32B模型

选择GPU配置后,下拉页面至底部,在选择镜像–预置模型镜像,点击选择QwQ-32B

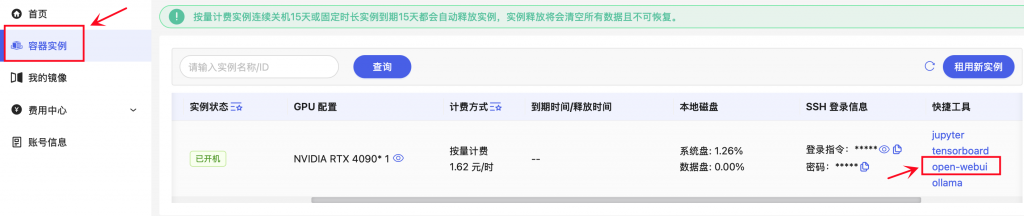

step 2:在快捷工具中打开

点开容器实例页面,在开机实例的快捷工具中,点击【open-webui】

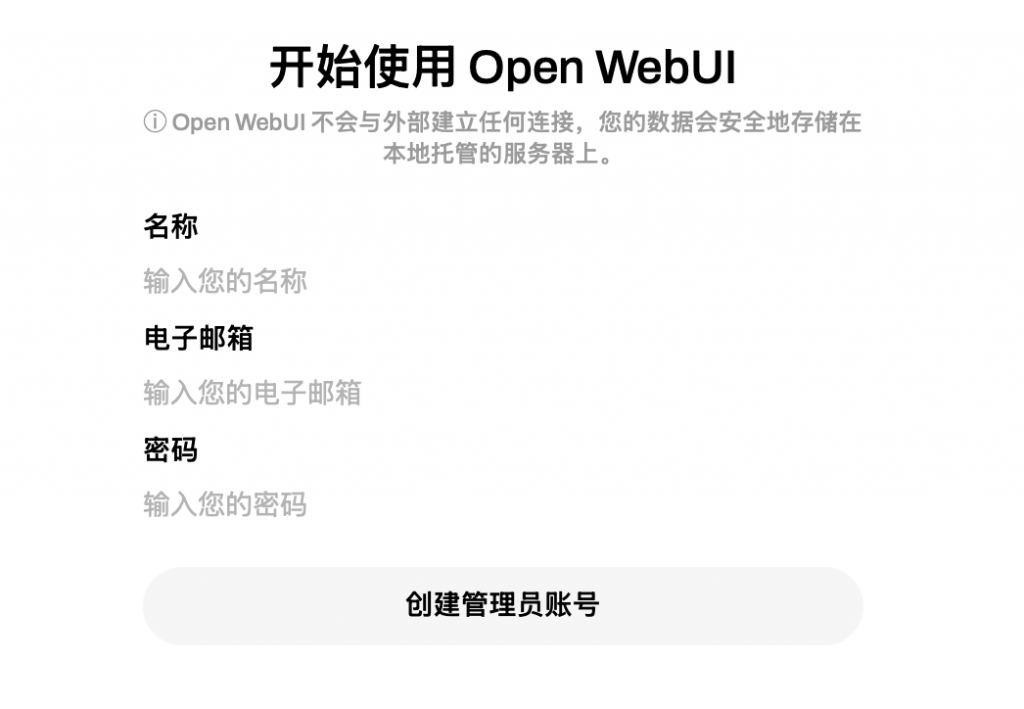

step 3:登录 Open WebUI

电子邮箱可任意写,不用激活验证。填完后,可保存登陆信息。

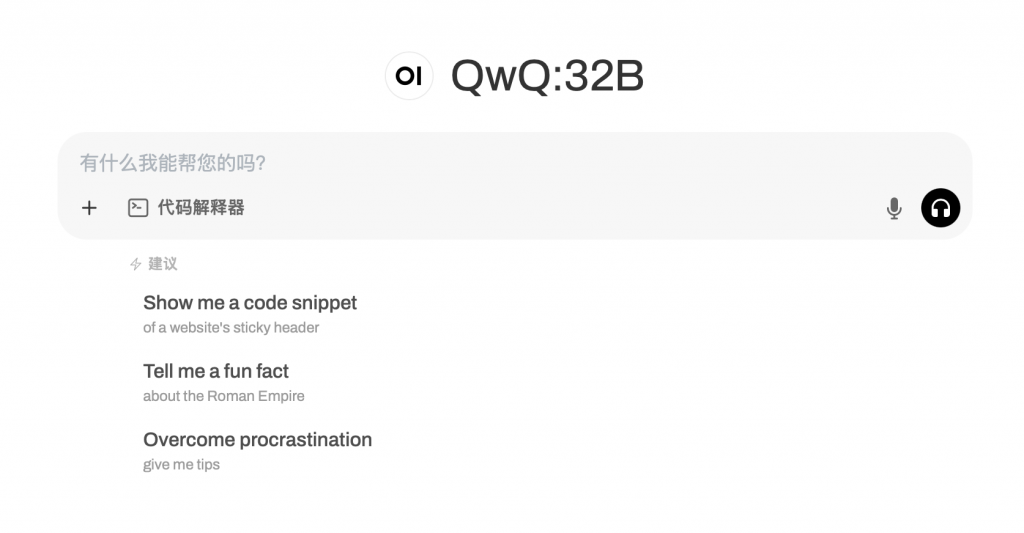

step 4:即可进入QwQ-32B交互页面

step 5:模型调用

成功进入页面后,您可以通过以下两种方式调用QwQ-32B模型:

方式一:通过WebUI直接交互

输入问题/指令:在WebUI的输入框中直接输入您的问题或任务指令(例如:“请用Python实现快速排序算法”),提交后即可收到实时返回的推理结果。

方式二:通过API调用(适合开发者)

1)获取API信息:

返回BuluAI容器实例页面,在实例的快捷工具中找到ollama,右键复制链接。

2)调用示例(Shell):

curl http://sh.tools.buluai.cn:40317/api/generate -d '{

"model": "QwQ:32B",

"prompt": "Why is the sky blue?",

"stream": false

}'3)处理响应:

API会返回JSON格式的结果,在自己的业务逻辑中正确的处理他们。

小贴士: